ソース:https://www.latent.space/p/gpu-bubble

Swyxのメモ:以前のゲストとの再会が続いています。Raza HabibとHamel Husainのチャットに最近ゲストとして登場したほか、Eugene Cheahがニュースレターの珍しいゲストライターとして復帰したことを嬉しく思います。Eugeneは現在、Featherless.AIを共同設立しています。これは、世界最大のオープンソースモデルコレクション(約2,000)を備えた推論プラットフォームで、単一のAPIを介して定額料金(月額10ドルから)で即座にアクセスできます。

最近、NVIDIAの新しいBlackwellシリーズがOpenAIに展開され、大きな盛り上がりを見せています。同社によれば、来年分の在庫は完売しており、ジェンスン氏は「業界史上最も成功した製品」になる可能性があると述べています。いとこのリサ氏が「MI3 25 X」を発表し、CerebrasがIPOを申請したことで、GPU市場に再び深く切り込む時期が来ています)。

6,000億ドルの疑問に対する答えはまだ出ているのでしょうか? 基礎モデルのトレーニングへの設備投資は「史上最速で減価する資産」であることは今やコンセンサスとなっていますが、GPUインフラへの支出についてはまだ結論が出ておらず、GPUリッチ戦争は激化しています。一方で、フロンティアラボは収益よりもトレーニング+推論に多くの費用を費やしており、史上最大のベンチャーラウンドで66億ドルを調達する一方で、2026年には140億ドルの損失を予測していることがわかっています。財務ロジックを解析するにはAGIが必要です。

幸いなことに、このことについてずっと考えている人がいます。以下は、現在推論プロバイダーとしてH100市場を深く掘り下げているEugeneのGPU経済に関する見解です。Blackwell世代の将来を予測する上で参考になるかもしれません。財務アドバイスではありません。Yangqing Jiaのガイドもおすすめです。

TLDR:H100を購入しないでください。予約済みコンピューティングの再販、オープン・モデルの微調整、新しい基盤モデル企業の減少により、市場は不足($8/時間)から供給過剰($2/時間)に転じました。代わりにレンタルしましょう。1

一般市場では、現在供給過剰となっているため、必要なときにほぼ原価でレンタルできる場合、新しいH100に投資するのはあまり意味がありません。

- AI競争の短い歴史

- その後6000億ドルの投資…

- 50,000米ドルのH100 SXM GPUのROIはいくら?

- 現在のH100バリューチェーン

- 市場動向: オープンウェイトモデルの台頭

- 供給増加とトレーニング需要減少を引き起こすその他の要因

- Featherless.AI プラグ …

AI競争の短い歴史

ChatGPTは2022年11月にA100シリーズをベースにして発売されました。H100は2023年3月に登場しました。投資家や創業者への売り込みはシンプルでした。A100と比較して、新しいH100は3倍の性能ですが、定価は2倍しかありません。

H100の導入が早ければ、より大きく優れたモデルを構築でき、OpenAIを飛び越えて汎用人工知能に躍り出ることもできます。ただし、OpenAIの財布に見合うだけの資金があればの話ですが。

この願望から、GPUを駆使したAIスタートアップに100億ドルから1,000億ドルが投資され、次の革命が起こりました。これが…

H100の需要急増

市場価格は急騰し、H100の当初のレンタル料金は1時間あたり約4.70ドルでしたが、8ドル以上になりました。次の1億ドルの資金調達ラウンドで投資家を説得するために、モデルのトレーニングを急いでいる必死の創業者たちにとって、これは朗報です。

For GPU farms, it felt like free money – if you can get these founders to rent your H100 SXMGPUs at $4.70 an hour or more, or even get them to pay it upfront, the payback period was <1.5 years. From then on, it was free-flowing cash of over $100k per GPU, per year.

With no end to the GPU demand in sight, their investors agreed, with even larger investments2…

GPUファームにとっては、それはタダのお金のように感じられました。これらの創設者にH100 SXMGPUを1時間あたり4.70ドル以上でレンタルしてもらうか、前払いしてもらうことができれば、回収期間は1.5年未満でした。それ以降は、1GPUあたり年間10万ドル以上の現金が自由に流れていました。

GPUの需要に終わりは見えないことから、投資家たちはさらに大きな投資に同意しました…2

その後6000億ドルの投資…

デジタル商品とは異なり、物理的な商品は遅延に悩まされます。特に、複数の配送遅延がある場合はそうです。

2023年のほとんどの期間、H100の価格は永遠に4.70ドルを超えるように感じられました(多額の前払い金を支払う意思がない限り)

2024年の初めには、H100の価格は複数のプロバイダーで約2.85ドルに達しました。

しかし、オンラインになるプロバイダーが増えるにつれて、次のようなメールが届くようになりました。

2024年8月には、H100時間のごく一部(数日から数週間)をオークションにかける気があれば、1時間あたり1ドルから2ドルでH100GPUを見つけられるようになります。

特に小規模クラスターでは、年間40%以上の価格低下が見込まれます。NVIDIAの4年間でGPU時間あたり4ドルというマーケティング予測は、1.5年足らずで消え去りました。

これは恐ろしいことです。なぜなら、誰かが損をする可能性が残されているからです。特に、新しいGPUとして購入したばかりの場合はなおさらです。では、何が起こっているのでしょうか。

50,000米ドルのH100 SXM GPUのROIはいくら?

ここでは、さまざまな市場レートに対する経済的コストとリースのROIに焦点を当てます。機会費用やビジネス価値ではありません。

データセンター内の平均的なH100 SXM GPUのセットアップ、保守、運用には5万ドル以上の費用がかかります(つまり、CAPEXの大部分)。電気代と冷却費のOPEXコストは除きます。計算の詳細については、この記事の後半で説明します。

しかし、これは今日の投資としてのユニット・エコノミクスにとって何を意味するのでしょうか。

特に、今日のGPU自体の寿命が5年であると仮定した場合。

一般的に、H100のリースには2つのビジネス・モデルがあり、それらについて説明します。

- 短期オンデマンドリース(時間単位、週単位、または月単位)

- 長期予約(3~5年)

オンデマンドリースのROI

要約すると、オンデマンドワークロードの場合

- >$2.85:株式市場のIRRを上回る

- <$2.85:株式市場のIRRに下回る

- <$1.65:投資損失を予想

上記のROIと収益予測の予測では、「ブレンド価格」を導入しました。これは、5年間でレンタル価格が徐々に50%まで下がることを想定したものです。

現在見られる年間40%以上の価格低下を考えると、これはおそらく保守的/楽観的な見積もりです。しかし、これは、一定の割合の価格低下を考慮しながらROIを予測する手段です。

ブレンド価格であっても1時間あたり4.50ドルでは、NVIDIAのデータ・センター・プロバイダーの当初の売り文句がわかります。この価格帯では、実質的に2年後には利益が生まれます。IRR(内部収益率)は20%以上です。

ただし、1時間あたり2.85ドルでは、IRRが10%をわずかに上回り始めます。

つまり、今日新しいH100サーバーを購入し、市場価格が1時間あたり2.85ドル未満の場合、100%の割り当てを想定すると(これは不合理な想定です)、市場に勝つことはほとんど不可能です。その価格を下回るのであれば、H100インフラ企業ではなく株式市場に投資したほうが得策です。

そして、価格が1時間あたり1.65ドルを下回ると、インフラ・プロバイダーとして5年間でH100で損失を出すことは間違いありません。特に、今年ノードとクラスターを購入したばかりの場合はそうです。

長期予約リース(3年以上)

多くのインフラプロバイダー、特に古いプロバイダーは、この点について無知ではありませんでした。なぜなら、彼らは暗号通貨時代の大幅な価格上昇後のGPUレンタル価格の大幅な下落で直接痛手を負っており、以前にもこのサイクルを経験していたからです。

そのため、昨年のこのサイクルでは、彼らは3〜5年の前払い契約および/または4ドル以上の価格帯での支払いを強く求めました(通常は50%~100%の前払い)。現在、彼らは2.85ドル以上の価格帯を押し上げ、利益を確保しています。

これは、2023年のAIピーク時に積極的に起こり、特に画像生成分野のさまざまな基盤モデル企業が、新しいクラスターの最前線に立ってターゲットモデルを最初に作成し、次のラウンドを完了するために、間接的に高額の3〜5年契約を強いられました。

これは最も経済的な動きではないかもしれませんが、競合他社よりも速く動くことができます。

ただし、これは興味深い市場動向につながっています。H100に1時間あたり3ドルまたは4ドルを支払う場合、今後3年間、契約に縛られます。

モデル作成者がモデルのトレーニングを終えると、クラスターは使用できなくなります。彼らはどうするでしょうか? – 再販してコストの一部を回収し始めます。

現在のH100バリューチェーン

ハードウェアからAI推論・微調整まで、大まかに次のように考えることができます。

- Nvidiaと提携しているハードウェア・ベンダー(1回限りの購入コスト)

- データセンター・インフラストラクチャ・プロバイダーとパートナー(施設スペースおよび/またはH100ノードの長期予約を販売)

- VCファンド、大企業、スタートアップ:基盤モデルの構築を計画している(またはすでにモデルの構築を完了している)

- キャパシティの再販業者:Runpod、SFCompute、Together.ai、Vast.ai、GPUlist.ai

- マネージドAI推論 / Finetuneプロバイダー:上記を組み合わせて使用している

スタックの下のどのレイヤーも垂直統合される可能性がありますが(たとえば、インフラ・プレーヤーをスキップするなど)、ここでの主な推進力は「未使用容量の再販業者」と、Llama 3などの「十分に優れた」オープン・ウェイト・モデルの台頭であり、これらはすべて、現在のH100の経済的圧力に大きな影響を与える要因です。

クローズドソースモデルと同等のオープンウェイトモデルの台頭。

市場に根本的な変化をもたらしています

市場動向: オープンウェイトモデルの台頭

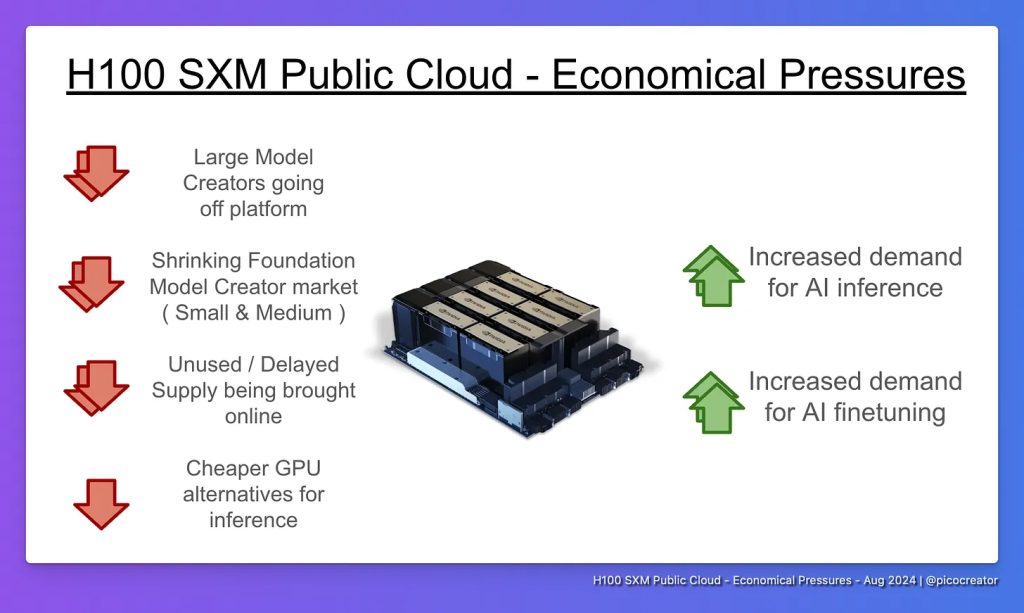

↑↑ AI推論と微調整の需要増加

多くの「オープン」モデルは適切な「オープンソース」ライセンスを欠いているにもかかわらず、無料で配布され、商業的にも広く使用されているためです。ここでは、これらを総称して「オープンウェイト」または「オープン」モデルと呼びます。

一般的に、様々なサイズの複数のオープンウェイトモデルが構築されるにつれて、推論と微調整の需要も増加しています。これは主に2つの大きな出来事によって推進されています。

- GPT4クラスのオープン・モデルの登場(例:405B LLaMA3、DeepSeek-v2)

- 小規模(~8B)および中規模(~70B)の微調整モデルの成熟と採用

現在、企業が必要とするほとんどのユースケースでは、既製のオープンウェイト・モデルがすでに存在します。これは、特定のベンチマークでは独自のモデルより少し遅れている可能性があります。

次の点で利点があります。

- 柔軟性:ドメイン/タスク固有の微調整

- 信頼性:ユースケースを壊すようなマイナーなモデル更新はもうありません(現在、モデルの重みがパブリックAPIエンドポイントで通知なしに静かに変更され、不可解な回帰が発生しないというコミュニティの信頼は低いです)

- セキュリティとプライバシー:プロンプトと顧客データが安全であることを保証します。

これらすべてが、推論と微調整の需要の増加とともに、オープン・モデルの現在の継続的な成長と採用につながっています。

しかし、別の問題も発生します…

中小模型メーカーの複合的な崩壊

↓↓ 縮小する基礎モデルクリエーター市場(中小)

モデルをゼロから作る組織を総称して「モデルクリエイター」と呼び、微調整を行う組織を「モデル微調整者」と呼ぶ。

多くの企業、および複数の中小規模の基礎モデル作成スタートアップ企業、特に「より小規模で専門化されたドメイン固有のモデル」を売り文句に資金調達を行った企業は、大規模な基礎モデルをゼロからトレーニングする長期的な計画や目標を持っていないグループです(>= 70B)。

どちらのグループも、「独自にトレーニングする」のではなく、既存のOpen Weightsモデルを微調整する方が経済的で効果的であることに気づきました。

これにより、H100の需要が減少するという三重の打撃が生じました。

- 微調整は、最初からトレーニングするよりも大幅に安価です。

- 微調整の要求は、ゼロからのトレーニング(7B以上のモデルでは16ノードから、通常はそれ以上)と比較して、コンピューティング要件(通常は4ノード以下、通常は1ノード)において大幅に少ないためです。

- この業界全体の切り替えにより、小規模なクラスターの要求の大部分が実質的に解消されました。

- 基盤モデル投資の縮小(中小規模)

- 2023年には、テキストと画像の分野で、小規模および中規模の基盤モデルの大きな波がありました。

- ただし、今日では、llama3を超えることができると確信しているか、何か新しいもの(新しいアーキテクチャ、100倍低い推論、100以上の言語など)を導入していない限り、基盤モデル企業がゼロから設立されることはほとんどありません。

- 一般的に、大手プレーヤー(’Facebookなど)によって作成された小規模および中規模のオープン・モデルでは、小規模プレーヤーが基盤モデルのトレーニングを正当化することが困難です(強力な差別化要因(テクノロジーまたはデータ)がある場合、または大規模なモデルに拡張する計画がある場合を除く)。

- これは最近、投資家にも反映されており、新しい基盤モデルの作成者の資金が急激に減少しています。小規模グループの大多数が微調整に切り替えています(この感情は、複数の企業の最近の望ましくないエグジットと相まって生じています)。

- 現在、私の推定では、世界中におよそ次のチームがあります:

- <20の大規模モデル作成チーム(別名70B++、小規模モデルも作成可能)

- <30の小規模/中規模モデル作成チーム(7B – 70B)

- 合計すると、基礎モデル・トレーニングを行うために、いつでも16ノードのH100(またはそれ以上)を市場に求めているチームは世界中に50チーム未満です。

- 世界中に16ノードを超えるH100クラスターが50以上あります。

- 予約ノードの余剰容量がオンラインになる

- クラスター所有者、特に2023年の最初の「土地獲得」で長期予約をしたさまざまな基盤モデルのスタートアップ企業やベンチャーキャピタルにとって。

- 微調整への切り替えとH100の非常に長い待ち時間(ピーク時は6か月以上)により、これらのグループの多くは変更を行う前にすでに前払いを行っていた可能性が非常に高く、基本的に前払いのハードウェアが「到着時に時代遅れ」になっていました。

- あるいは、最初のいくつかのモデルをトレーニングするためにハードウェアが時間どおりに到着した人たちも、次のモデルのイテレーションを微調整する方が良いという同じ認識に至っていました。自分で構築するのではなく。

- どちらの場合も、未使用の容量があり、それは「コンピューティング再販業者」が市場供給に参加することでオンラインになります…

供給増加とトレーニング需要減少を引き起こすその他の要因

1)大規模モデル作成者がパブリック・クラウド・プラットフォームから離脱

もう1つの大きな要因は、Facebook、X.AI、そしておそらくOpenAI(Microsoftの一部とみなす場合)などの主要なモデル作成者が既存のパブリック・プロバイダーから離れ、独自の10億ドル規模のクラスターを構築し、既存のクラスターが依存する需要を排除していることです。

この動きは主に次の理由で起こっています。

- 既存の約1,000ノードのクラスター(構築に5,000万ドル以上かかる)は、より大きなモデルをトレーニングするにはもはや十分ではありません

- 10億ドルの規模では、会計上、純然たる経費リースではなく、帳簿価格(会社の評価と資産の一部)のある資産(サーバー、土地など)を購入する方がよいでしょう。

- 人材がいない場合は(人材はいます)、これを構築する専門知識を持つ小規模なデータセンター会社を直接購入することもできます。

需要が段階的に減少するにつれて、これらのクラスターはパブリック・クラウド市場にオンライン化されつつあります。

2)未使用/遅延供給がオンラインになる

H100の大量出荷が2023年に遅れた、あるいは6か月以上遅れたことを覚えていますか? これらは現在、H200、B200などとともにオンラインになっています。

これと並行して、さまざまな未使用のコンピューティングがオンラインになっています(前述のように、既存のスタートアップ、企業、またはVCから)。

この大半は、together.ai、sfcompute、runpod、vast.aiなどのコンピューティング・リセラーによって行われます。

ほとんどの場合、クラスター所有者は、十分に活用されていない小規模または中規模のクラスター(通常は8~64ノード)を所有しています。クラスターにすでに「費やされた」お金があります。

主な目標はコストを可能な限り回収することであるため、主要なプロバイダーと競合して割り当てがない可能性もある代わりに、市場を下回って割り当てを保証します。

これは通常、固定料金、オークション・システム、または単なる自由市場リストなどを介して行われます。後者の2つは市場価格を押し下げます。

3)より安価なGPUの代替品(特に推論用)

もう1つの大きな要因は、トレーニング/微調整スペースの外に出たときです。推論スペースには、特に小規模なモデルを実行している場合は、代替手段が満載です。

H100のInfinibandやnvidiaによって発生するプレミアムを支払う必要はありません。

a)Nvidiaの市場セグメンテーション

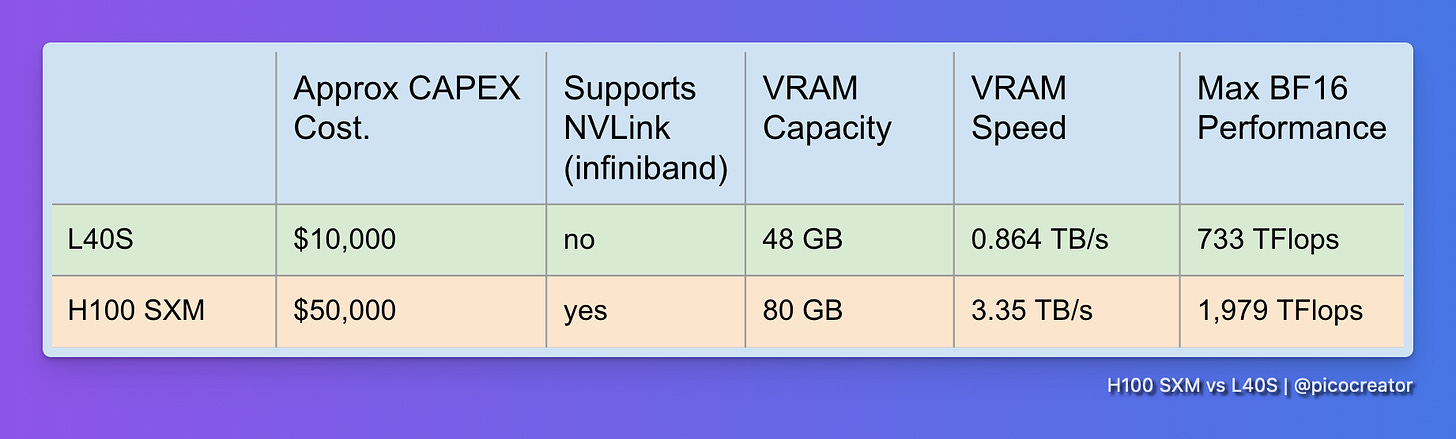

トレーニング用のH100プレミアムはハードウェアの価格に含まれています。たとえば、NVIDIA自身は推論用のより価格競争力のある代替品であるL40Sを推奨しています。

パフォーマンスは1/3、価格は1/5です。ただし、マルチノード・トレーニングではうまく機能しません。このセグメントでは、自社のH100よりも低価格です。

b)AMDとIntelの代替プロバイダー

AMDとIntelは、それぞれMX300とGaudi 3で、このゲームに遅れて参入した可能性があります。

これは、これらのシステムを使用してテストおよび検証されています。一般的に、次のようになります。

- 購入コストはH100より安い

- H100よりもメモリとコンピューティング能力が高く、単一ノードではパフォーマンスが優れています。

- 全体的に、優れたハードウェアです。

問題は、トレーニング中にドライバーに小さな問題があり、大規模なマルチノード・クラスター・トレーニングではまったく実証されていないことです。

前述のとおり、これは現在の状況とはほとんど関係ありません。50チーム未満のチーム以外にとっては関係ありません。H100の市場は、推論と単一または小規模のクラスターの微調整に移行しています。

これらのGPUは、これらすべてで動作することが実証されています。ユース・ケースでは、市場の大多数が求めています。

これら2つの競合製品は、完全なドロップイン・リプレースメントです。既製の推論コード(例:VLLM)または最も一般的なモデル・アーキテクチャ(主にLLaMA3、次にその他)の微調整コードが動作します。

したがって、互換性が整理されている場合は、ぜひ確認することをお勧めします。

c)暗号/Web3空間におけるGPU使用の減少

Ethereumがプルーフ・オブ・ステークに向かい、ASICがビットコイン・マイニング競争を支配し、暗号通貨市場全体が好調です。

暗号通貨マイニングにおけるGPUの使用は減少傾向にあり、いくつかのケースでは採算が取れません。そしてそれ以来、GPUパブリック・クラウド市場にあふれています。

これらのGPUの大部分は、ハードウェアの制約(PCIe帯域幅の低さ、ネットワークなど)により、トレーニングや推論にさえ使用できません。ハードウェアは市場にあふれ、AI推論ワークロードに再利用されています。

ほとんどの場合、10B未満であれば、これらのGPUですぐに、非常に低価格でまともなパフォーマンスを得ることができます。

さらに最適化すれば(さまざまなトリックを使って)、このハードウェアの小さなクラスターで大規模な405Bモデルを実行することもできます。これは、通常使用されるH100ノードよりも安価です。

H100 価格は商品価格より安くなっています。

あるいは、赤字で賃貸されているかもしれません。もしそうなら、今はどうしますか?

考えられる影響は何でしょうか?

中立:H100クラスター価格のセグメンテーション

大まかに言うと、他に選択肢がないため、大規模なクラスターは依然としてプレミアム料金(>=2.90ドル/時間)を請求することが予想されます。本当に必要な人向けです。

たとえば、Voltage Parkでこの傾向が見られ始めています。

Infinibandを使用したクラスターは割高な料金が請求されます。

一方、推論にはまったく問題のないEthernetベースのインスタンスは、より低い料金で請求されます。それぞれのユースケース/可用性に合わせて料金を調整します。

基盤モデル作成チームは全体的に減少していますが、オープンウェイトや代替アーキテクチャの増加により、再び増加するかどうかは予測が困難です。

また、将来的には、クラスター・サイズによるセグメンテーションがさらに進むと予想されます。Infinibandを使用した大規模な512ノード・クラスターは、16ノード・クラスターよりもGPUあたりの料金が高くなる可能性があります。

悪い点:遅れて登場した新しいパブリック・クラウドH100クラスターは利益が出ない可能性があり、一部の投資家が損害を被る可能性。

2.25ドルを下回る価格設定にすると、OPEXによっては利益が出ないリスクがあり、不利な点が多くあります。

3ドル以上の高すぎる価格設定にすると、キャパシティを満たすのに十分な購入者を獲得できない可能性があります。

遅れると、初期の4ドル/時間ではコストを回収できない可能性があります。

全体として、これらのクラスターへの投資は主要な利害関係者と投資家にとって厳しいものになるでしょう。

そうではないと思いますが、新しいクラスターがAIポートフォリオ投資の大きな部分を占める場合、資金難に陥った投資家からの追加の波及効果が資金調達エコシステムに見られるかもしれません。

中立:中規模から大規模のモデル作成者、長期リースを購入し、プレミアムですでに価値を引き出されている

ネガティブな見通しではなく、ニュートラルな見通しは、オンラインになる未使用のコンピューティング基盤モデル作成者の一部がすでに支払われているというものです。

資金調達市場ではすでにこのクラスターとそのモデルトレーニングの価格が決定され、支払われています。そして、現在の資金調達ラウンドと次の資金調達ラウンドに使用された「価値を引き出し」ました。

これらの購入のほとんどは、コンピューティング再販業者が人気になる前に行われたため、コストはすでに価格に反映されていました。

どちらかといえば、彼らが余剰のH100コンピューティングから得ている現在の収益と、私たちが得る低価格は、双方にとって有益です。

そうであれば、市場へのマイナスの影響は最小限であり、全体としてエコシステムにとってはプラスの勝利です。

良い点:安価なH100は、オープンウェイトAI採用の波を加速させる可能性

オープンウェイトモデルがGPT-4クラスのアリーナに参入したことを考えると、H100の価格が下がることは、オープンウェイトAIの採用の乗数ロック解除となるでしょう。

愛好家、AI開発者、エンジニアにとって、これらのオープンモデルを実行、微調整、およびいじくり回すことがより手頃になります。

特にGPT5++に大きな飛躍がなければ、オープンウェイトとクローズドソースモデルの間のギャップが曖昧になることを意味します。

市場は現在持続可能ではないため、これは強く必要です。有料ユーザー向けのアプリケーション層での価値獲得が不足しているため(プラットフォーム、モデル、およびインフラ層に流れ込みます)、

ある意味では、誰もがシャベルを構築していて(私たちも含めて)、有料ユーザーがいるアプリケーションが構築されていない(収益と価値を集めていない)場合です。

しかし、AI推論と微調整がこれまで以上に安価になると。

AIアプリケーションの波が潜在的に始まる可能性があります。まだゆっくりと始まっていない場合はそうです。

結論:新品のH100は買わないでください

新しいH100のハードウェアへの支出はおそらく損失をもたらすでしょう

ただし、割引されたH100、割引された電気、またはGPUの場所が顧客にとって重要であるSovereign AIの角度の組み合わせがある場合、または数十億ドルを所有していて超大規模なクラスターが必要な場合、投資する場合は、他の場所に投資することを検討してください。または、より高い収益率を求める場合は、株式市場指数自体を検討してください。

Featherless.AI プラグ …

私たちがしていることは…

Featherless.AIでは、現在、世界最大のオープンソースAIモデルのコレクションをホストしています。サーバーレスで即座にアクセスでき、リクエストは無制限で月額10ドルから、固定料金でご利用いただけます。

現在、2,000を超えるモデルをインデックス化し、推論の準備を整えています。これは、最大のモデル・プロバイダー・アグリゲーターであるopenrouter.aiのカタログの10倍であり、サーバーレスで即時推論に利用できる世界最大のOpen Weightsモデルのコレクションです。高価な専用GPUは必要ありません。

当社のプラットフォームでは、数秒でモデル間のホットスワップを動的に実行できるため、これが可能になります。

使いやすいように設計されており、OpenAI APIとの完全な互換性があるため、AIエージェントの既存のAI APIの代わりに当社のプラットフォームを接続するだけで済みます。バックグラウンドで実行されています。

これらすべてを実行します。AIは、言語や社会的地位に関係なく、誰もが簡単にアクセスできるべきだと信じているからです。

私たちが他の推論プロバイダーと異なることを決意した理由…

この記事に関連する技術的な側面について。

ペタバイト相当のAIモデルを持ち、成長を続け、24時間365日稼働させながら、ハードウェア収益を上げ続ける(私たちは収益を上げています) のは、GPUハードウェアの選択方法に至るまで、プラットフォームのすべてのレイヤーを最適化する必要があったため、課題です。

典型的な推論プロバイダーの売り込みは、通常、データ・センターの特別な利点と、独自のハードウェアで実行するCUDA最適化で勝つという内容です。ハードウェアはCAPEX集約型です(これは現在でも売り込みと資金提供が行われています)。

私たちは、ほとんどの投資家の感覚に反して、その逆を言っていました。つまり、新しいハードウェアの購入は避けると言っていたのです。

これまでの数十億ドルのハードウェア投資のおかげで、ほとんどの投資家、アナリスト、創業者が気付かなかったことに気付きました。GPUはコモディティ・ハードウェアです。私たち全員が予想していたよりも高速です。

特定の場所では2.85ドルというコモディティ・レベルの価格に達していることに気づいている投資家はほとんどいません。ましてや1ドルという赤字価格など、なおさらです。ほとんどのプロバイダー(特定の例外は除く)は、見積もり後またはログイン後にのみ完全な価格を表示するためです。

そして、それがこの記事を書くきっかけとなりました。

私たちは推論CUDAとカーネルも最適化しています。ハードウェア側では、ハードウェアのコモディティ化に賭け、代わりに上のオーケストレーション・レイヤーに焦点を当ててきました。

つまり、私たちにとっては、AWSスポット(推奨)から、セキュリティとネットワークのコンプライアンスが私たちの基準を満たすさまざまなデータ・センター・グレードのプロバイダー(Tensordock、Runpodなど)まで、さまざまなソースが混在しています。

これらを独自のモデル・ホット・スワップで活用し、新しいモデルを1秒未満で起動します。低コストの投機的デコーダーとしてRWKV基盤モデルのカスタム・バージョンを使用しながら、GPU群をワークロードに合わせて適切なサイズに保ちます。これらすべてにより、H100に代わる新しい(および古い)GPUが登場するにつれて、この市場トレンドと将来のGPU価格の低下を最大限に活用できます。そして、積極的に拡張できます。

追伸:世界最大の推論プラットフォームの構築を検討しており、言語やステータスに関係なく、すべての人がAIにアクセスできるようにするという当社の目標に賛同している場合は、hello@featherless.aiまでご連絡ください。

追加情報源:

- GPUデータ:Tech Power Upデータベース。A100 SXMは624 bf16 TFlops、H100 SXMは1,979 bf16 TFlopsでした

- MicrosoftとAWSはAIインフラだけで400億ドル以上を割り当てました:ウォール・ストリート・ジャーナル

- 2014年10月のNvidia投資家向けスライド:14ページに「データ・センター」の売り込みがあります

- セミ分析:H100クラスターの詳細、コンポーネントの寿命は約5年

- スプレッドシート:新しいH100 ROI(2024年8月)

- スプレッドシート:H100 Infinibandクラスターの計算(2024年8月)

ただし、割引されたH100、割引された電気、またはGPUの場所が顧客にとって重要であるソブリンAIの角度の組み合わせがある場合、または数十億ドルの資産があり、最先端のモデルトレーニングのために超大規模なクラスターが必要な場合は別です。

引用されている「6000億ドル」はセコイア・デイビッド・カーンの記事に関するものです。

コメント